[GAM]램버스, AI 반도체 랠리 소외…'캐치업' 시작된다①

컨텐츠 정보

- 139 조회

- 10 추천

- 목록

본문

이 기사는 11월 28일 오후 3시48분 '해외 주식 투자의 도우미' GAM(Global Asset Management)에 출고된 프리미엄 기사입니다. GAM에서 회원 가입을 하면 9000여 해외 종목의 프리미엄 기사를 보실 수 있습니다.

[서울=뉴스핌] 이홍규 기자 = 올해 들어 주가가 10% 넘게 하락한 미국의 메모리 인터페이스 칩 업체 램버스(종목코드: RMBS)에 대해 월가에서 인공지능(AI) 부문의 필수 보유 종목이자 저평가 주식이라는 평가가 나오고 있다. 데이터센터의 인공지능(AI) 연산용 서버로의 전환 속도가 빠르게 전개되면서 종전 주가 하락의 원인이었던 전통 서버 쪽에서의 수요 부진을 조속히 만회할 것이라는 전망이 제시된다.

1. 반도체 랠리 소외

램버스의 주가는 현재 57.12달러(27일 종가 기준)로 올해 들어 16% 하락했다. 같은 기간 미국의 반도체 주식들의 시세가 전방위적인 AI 연산용 수요 확산 기대감에 힘입어 큰 폭으로 뛰어오른 것과 극명한 대조를 이룬다. 필라델피아반도체 주가지수가 연초 이후 16% 상승한 가운데 램버스와 비슷하게 메모리 분야 기업으로 분류되는 칩 제조업체인 마이크론테크놀로지(MU)는 15% 뛰었다.

|

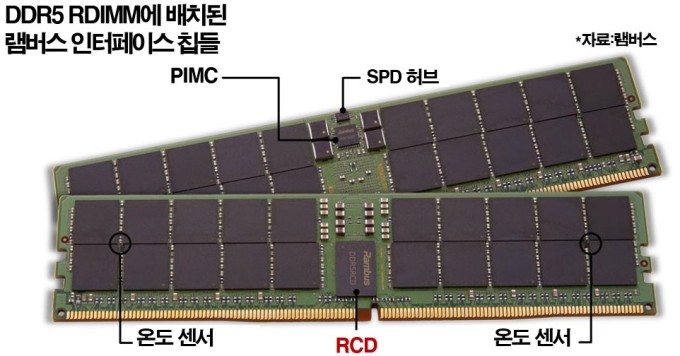

램버스는 메모리와 CPU가 서로 통신할 수 있도록 하는 인터페이스 칩을 판매하는 회사다. 여러 개의 DRAM이 장착된 긴 직사각형 모양의 회로기판(메모리 모듈) 중앙이나 상단에 위치한다. 정확하게는 CPU와 직접 통신하는 게 아니라 대부분 CPU 내부에 있는 '메모리 컨트롤러'와 DRAM 칩 사이의 통신을 관리하는 역할을 한다. 다르게 표현하면 CPU라는 프로세서와 메모리를 각각 대표하는 중개자 간의 통신인 셈이다.

램버스는 ①인터페이스 칩을 판매할 뿐 아니라 ②칩의 설계도를 라이선스하는 사업도 전개한다. 칩은 직접 제조하지 않고 외부에 맡기는 팹리스 형태다. 제품 매출액과 라이선스(로열티) 매출액 비중은 각각 46%와 44%로 대동소이하다. 나머지는 ③계약 및 기타(10%)로 분류되는 사업에서 발생하는데 관련 사업은 고객과의 맞춤형 계약이나 기술 지원·컨설팅, 연구·개발 협력 등을 담당한다.

램버스의 주가가 올해 들어 하락한 것은 전통 서버 수요와 관련이 있다. 램버스의 메모리 모듈용 인터페이스 칩은 그동안 CPU가 연산 작업의 중심이 되는 전통 데이터센터 쪽에서 수요가 많았다. 하지만 고객사들이 관련 데이터센터를 GPU가 중심이 되는 AI 연산용 서버로 전환하면서 램버스의 인터페이스 칩의 수요는 감소하게 됐다. 이에 따라 램버스의 실적은 투자자들의 기대치를 밑도는 결과를 내게 됐다.

2. "캐치업 시작된다"

그럼에도 전문가들이 램버스에 대해 낙관하는 이유는 실적 부진 현상이 일시적일 것으로 봐서다. 메모리 모듈용 인터페이스 칩은 GPU와 HBM 등으로 구성된 AI 연산용 칩셋에서도 쓰이기 때문이다. 종전까지 전통 서버에서의 수요가 컸던 터라 AI 연산용 칩셋 수요에 의한 매출 증가분이 아직 이를 상쇄하지 못했을 뿐이라는 얘기다. 다시 말해 과도기적 상황에 으레 나타나는 현상이라는 것이다.

|

AI 연산용 칩셋에서는 GPU와 HBM이 핵심 구성품이긴 하지만 CPU는 여전히 중요한 역할을 한다. 연산 작업을 GPU에 분배하고 전반적인 데이터 흐름을 제어한다. 즉 GPU가 AI 연산을 수행하는 동안 CPU는 이러한 작업이 원활히 진행되도록 조율하는 역할을 담당하는 것이다. 엔비디아가 고성능 AI 연산용 칩셋으로 제시한 GB200에는 1개의 CPU와 2개의 GPU로 구성돼 있다.

이런 AI 연산용 칩셋의 물리적 구조에서 DRAM은 계속 중요한 역할을 한다. DRAM을 적층해 만들어진 HBM이 GPU와 가깝게 위치하며 고속으로 GPU에 데이터(영구 저장장치에서 데이터를 가져와 일시적으로 HBM에 저장)를 공급하고 있어 기존 DRAM 필요성에 의문이 들 법도 하지만 HBM은 저장 용량 면에서 한계가 있어 DRAM이 필요하다.

마치 HBM이 요리사의 조리대처럼 당장 요리에 써야 하는 재료만 올려두는 공간이라면 DRAM은 식당의 창고처럼 곧 필요한 재료나 임시로 보관해야 할 것들을 두는 공간으로 볼 수 있는 셈이다. HBM이 용량 한계에 직면한 경우 CPU는 HBM에 어떤 데이터를 공급할지 DRAM에서 필요한 자료를 확인한다. 이런 부품간 긴밀한 관계상 AI 연산용 칩셋에서 램버스의 메모리 인터페이스 칩은 수요가 없을 수밖에 없다.

|

| [사진=램버스 홈페이지 갈무리] |

▶②편에서 계속

bernard0202@newspim.com

관련자료

-

이전

-

다음